※ Wired의 「GREEDY, BRITTLE, OPAQUE, AND SHALLOW: THE DOWNSIDES TO DEEP LEARNING」를 번역한 글입니다.

구글 최고 경영자 선다 피차이는 말했습니다.

AI(인공지능)는 전기나 불보다 더 심오하다.

구글 브레인을 설립하고, AI 스타트업에 투자하고 있는 앤드류 옹은 말했습니다.

보통 사람이 1초보다 짧은 시간 동안 하는 생각에 기반한 두뇌 작업은, 지금이나 가까운 미래에 AI로 자동화될 수 있을 것입니다.

그들의 열정은 이해할 수 있습니다. 몇십 년의 좌절 후 AI 분야에서는 놀라운 진보가 일어났습니다. 오늘날 우리는 알렉사 같은 음성 인식 개인 비서에게 “텔레비전 밴드의 음악을 틀어달라.”라고 말하거나, 페이스북이 자동으로 달아주는 사진 태그에 의존하고 있죠. 구글 번역은 종종 인간 번역가만큼 정확합니다.

지난 5년 동안, 몇십억 달러의 연구 기금과 벤처 자금이 AI 분야로 흘러 들어갔습니다. AI는 매사추세츠공과대학교와 스탠퍼드 대학교의 컴퓨터 공학 전공에서 가장 인기가 많은 수업입니다. 실리콘 밸리에 최근 채용된 AI 전문가는 50만 달러의 급여와 주식을 받습니다.

하지만 똑똑한 기계가 하지 못해도, 사람은 빠르게 처리할 수 있는 일들이 아직 많이 남아 있습니다. 자연어는 딥러닝보다 뛰어납니다. 소가 소 우리 앞에서 갑자기 멈춰서는 것처럼, 인공지능은 새로운 상황에 잘 대처하지 못하죠. 이 단점은 해결되는 데 많은 시간이 필요할 것 같습니다.

이미 단점이 존재한다는 사실을 인지하면, 계속 이런 한계에 대해 생각할 수밖에 없습니다. 인공지능 분야의 지배적인 기술이 된 딥러닝은 AI가 추상적 추론이나 세계에 대한 일반화를 할 수 있도록 만들지는 못합니다. 즉, 현재 수준에서는 AI가 일반 사람들이 수행하는 모든 작업을 자동화시키기 어려워 보인다는 것입니다.

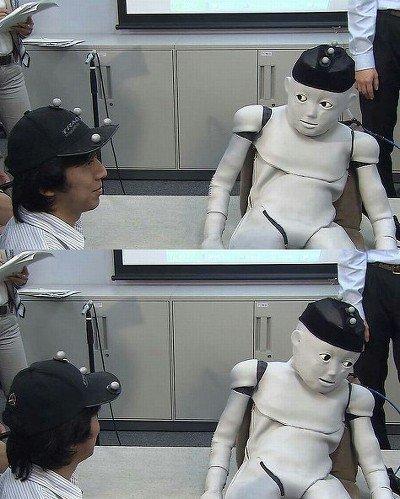

“로봇은 병을 드는 법을 배워도, 컵을 들 수는 없습니다”

왜 AI가 어떤 작업에서는 뛰어난 수행 능력을 보여주는 반면, 다른 작업에서는 제대로 역할을 수행하지 못할까요? 이를 알아보기 위해서는 딥러닝이 어떻게 작동하는지 살펴보는 게 도움될 것입니다.

딥러닝은 수학입니다. 컴퓨터가 신경망 네트워크를 이용해서 패턴을 분류하는 법을 배우는 통계적 방법론이죠. 우리 뇌의 뉴런과 비슷하게, 입력과 출력 기능을 가지고 있습니다. 네트워크는 많은 수의 노드(node)가 연결된 여러 개의 중간층을 가지고 있죠. 이 네트워크는 흔히 ‘딥(deep: 깊은)’하다고 여겨집니다. 그래서 딥러닝은 노드 간 수학적 가중치를 조정해 입력값이 적절한 출력 값을 가지도록 역전파 알고리즘을 이용합니다.

예를 들어, 음성 인식에서는 음소 ‘c-a-t’으로 ‘cat’이라는 단어를 만듭니다. 영상 인식에서 고양이 사진이 ‘개dog’로 표현되어서는 안 되겠죠. 그래서 “qui canem et faelem ut deos colunt”란 문장은 “개와 고양이를 신처럼 숭배하는 사람들”로 번역되어야 합니다. 이를 위해서 미리 공들여 표시해 놓은 수백만, 수십억의 예시를 통해 딥러닝 신경망이 음소, 사진, 라틴어와 영어와의 관계를 인식하도록 ‘지도(supervised)’됩니다.

딥러닝의 진보는 패턴 인지의 결과물입니다. 신경망은 사물의 종류(classes of things)를 기억한 뒤, 다음번에 같은 사물을 맞닥뜨리면 이를 분류합니다. 하지만 문제는, 인지 분야의 흥미로운 문제 대부분은 분류 작업과 관련되어 있지 않다는 겁니다. 구글 연구자 프랑소와 숄레는 이렇게 말합니다.

사람들은 100배 더 많은 계층과 1000배 더 많은 데이터가 있다면, 신경망이 사람이 하는 모든 작업을 대체할 수 있다고 순진하게도 믿죠. 이는 사실이 아닙니다.

뉴욕대학교 인지 심리학 교수이자 우버의 AI 연구소 책임자를 맡았던 게리 마커스는 딥러닝을 비판적으로 평가한 에세이 3부작을 최근 출간했습니다. 그는 딥러닝이 “일반적인 해법이 아닌, 많은 도구 중 하나”라고 믿습니다. 또한, 그는 AI가 패턴 인식이 풀지 못하는 여러 문제를 덮어둔 채 새로운 접근법 없이 벽을 향해 달려가고 있다고 걱정합니다.

이 모든 주장이 틀렸다고 무시하는 페이스북의 인공지능 연구 책임자 얀 러쿤과, 딥러닝이 곧 맞이할 장애물의 ‘증거’가 없다고 보는 역전파 알고리즘의 아버지 토론토대학교의 제프리 힌튼 교수를 제외한 AI 분야의 지도자들 대부분은 마커스의 관점을 조용히 공유하고 있습니다.

마커스 같은 회의론자에 따르면 딥러닝은 탐욕스럽고, 불안정하며, 이해하기 어렵고, 피상적입니다. 많은 훈련 데이터가 필요하다는 점에서 딥러닝 체계는 탐욕스럽습니다. 또한, 훈련 단계에서 사용된 시나리오와 다른 시나리오를 직면할 경우 상황에 맞게 고려해 변형하지 못한다는 점에서 불안하죠. 신경망의 매개 변수는 수학적 지리 안에서의 가중치에 관한 해석만이 가능합니다. 디버깅이 가능한 정형화된 코드를 가지고 있는 전통적인 프로그램과는 다르다는 점에서 불투명하죠.

다시 말해, 딥러닝의 출력은 블랙박스를 통해 산출되고, 설명될 수 없습니다. 당연히 신뢰성과 편견에 의심을 불러일으킬 수밖에 없죠. 마지막으로 딥러닝은 적은 양의 지식에 기초해 프로그램화되어 있고, 세계와 인간 심리에 대한 상식을 가지고 있지 않다는 점에서 피상적입니다.

이러한 한계는 AI를 과장해 옹호하는 사람들이 상상하는 것보다 자동화를 달성하기 힘들다는 점을 의미합니다. 이에 대해 『마스터 알고리즘』의 저자이자 워싱턴대학교 컴퓨터과학과 교수 페드로 도밍고스는 이렇게 설명합니다.

“로봇 제어에 대해서 생각해보세요. 로봇은 병을 드는 법을 배울 수 있습니다. 하지만 만약 로봇이 컵을 들어야 한다면 어떨까요? 로봇은 처음부터 다시 시작해야 하죠.”

우리는 기계보다 훨씬 나은 러닝 알고리즘을 가지고 있습니다

1월, 페이스북은 문자에 기반을 둔 가상 비서 엠(M)을 포기했습니다. 페이스북은 사람이 엠의 딥러닝 체계를 보충하고 훈련하게끔 했지만, 엠은 여전히 자연적으로 유용한 제안을 제공하거나 언어를 사용하지는 못했습니다. 무엇이 문제일까요?

우리는 기계가 사용하는 어떤 것보다도 나은 러닝 알고리즘을 머릿속에 가지고 있습니다.

도밍고스의 말입니다. 회의론자들은 더 좋은 머신러닝 방법에 투자할 필요가 있다고 단언합니다. 그래서 마커스는 AI 문제의 해결책으로 혼합주의(syncretism)를 이야기합니다. 딥러닝에 미리 학습된 데이터에 많이 의존하지 않는 비지도 학습 기술과, 딥러닝이 떠오르기 전 AI를 지배했던 세계를 설명하는 옛날 방식인 논리적인 규칙을 결합하는 것이죠.

마커스는 가장 좋은 지능 모델이 우리 자신이라고 주장합니다. 또한 사람의 강점에 관해서도 이야기하죠. 예를 들어 어린아이들은 많은 예 없이도 언어의 일반적인 규칙을 배울 수 있는 선천적인 능력을 갖추고 태어납니다.

우리는 세계에 인과관계가 있고, 전체는 부분으로 구성되어 있으며, 세계가 공간과 물질로 구성되어 있고, 이는 시간과 공간 속에서 계속된다는 점을 안 채로 태어납니다. 하지만 어떤 기계도 역전파 알고리즘을 통해 위 사실을 배울 수 없습니다.

그렇다면 다른 연구자들은 어떻게 생각할까요? 페드로 도밍고스는 이렇게 말합니다.

우리는 1950년대 이래로 똑같은 (머신 러닝을 위한) 기본적인 패러다임을 사용해왔습니다.

숄레는 “결국 가장 중요한 사실은 새로운 아이디어가 필요할 것이라는 점입니다.”라고 말하며 자동으로 다른 프로그램을 만들어내는 프로그램 합성에서 영감을 찾고 있습니다. 힌튼은 딥러닝을 위한 역전파 알고리즘을 보존하면서도 알고리즘의 한계를 다루는 ‘캡슐’을 연구하고 있습니다.

AI에는 아직 완전히 해결되지 않은 핵심적인 문제가 많이 있습니다. 심지어 아직 밝혀지지 않은 문제도요.

우리는 이 문제에 대답해야만 합니다. 화장실 청소나 포르노 분류같이 많은 사람이 하고 싶어 하지 않는 일들이 있기 때문입니다. 또는, 병을 치료할 약을 찾아내는 것처럼 기계가 더 잘할 수 있는 일도 있습니다. 더 많게는, 우리가 아직 상상하지 못하는 사람이 전혀 할 수 없는 일들이 있을 수도 있죠.

원문: 뉴스페퍼민트